ديبسيك تواجه اتهامات بسبب نموذجها الجديد R1

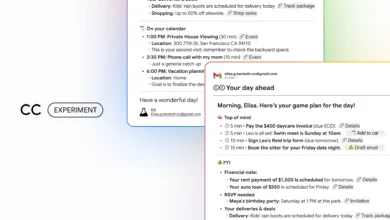

سلاسل تفكير نموذج ديب سيك تُشبه نماذج جيميناي.

أصدرت شركة الذكاء الاصطناعي الصينية DeepSeek الأسبوع الماضي إصداراً محدثاً من نموذجها المتقدم للمنطق والتحليل R1-0528، والذي أظهر أداءً قوياً في العديد من اختبارات البرمجة والرياضيات.

ورغم عدم إفصاح الشركة عن مصدر البيانات التي استخدمتها لتدريب النموذج، إلا أن عدداً من الباحثين في مجال الذكاء الاصطناعي يشتبهون في علاقة بين “جزء من تلك البيانات” وعائلة نماذج Gemini التابعة لشركة Google.

هل تم تدريب DeepSeek R1 على مخرجات جيميناي؟

أشار المطوّر الأسترالي سام بيتش (Sam Paech)، المتخصص في تصميم اختبارات الذكاء العاطفي لنماذج الذكاء الاصطناعي، إلى ما وصفه بأدلة تدعم هذا الادعاء، في منشور على منصة X (تويتر سابقاً)، قال بيتش:

يُظهر نموذج R1-0528 تفضيلاً لاستخدام تعبيرات ولغة مشابهة لتلك التي تعتمدها نسخة جيميناي 2.5 Pro، وهو ما يعزز احتمالية تدريب ديب سيك على مخرجات هذا النموذج.

لا تُعد هذه الملاحظة دليلاً قاطعاً، لكنها حظت بدعم مطوِّرٍ آخر يُعرف باسم SpeechMap -وهو صاحب مشروع لتقييم حرية التعبير في نماذج الذكاء الاصطناعي- إذ لاحظ أن “سلاسل التفكير” التي يُنتجها نموذج ديب سيك تُشبه إلى حد كبير تلك الناتجة عن نماذج جيميناي.

اتهامات سابقة لديب سيك باستخدام مخرجات شات جي بي تي

لم تكن هذه المرة الأولى التي تُتهم فيها ديب سيك بتدريب نماذجها على بيانات من منافسين، ففي ديسمبر الماضي، لاحظ بعض المطورين أن النموذج DeepSeek-V3 كان يعرِّف نفسه أحياناً على أنه ChatGPT، مما أثار الشكوك بأنه دُرّب على سجلات محادثات تعود إلى منصة OpenAI.

وفي وقت سابق من هذا العام، كشفت أوبن آي آي لصحيفة Financial Times أنها اكتشفت أدلة تربط ديب سيك باستخدام تقنية تُعرف باسم التقطير (Distillation)، وهي أسلوب لتدريب النماذج عبر استخراج المعرفة من نماذج أكبر وأكثر تطوراً.

ووفقًا لتقرير من بلومبرج، فقد اكتشفت شركة مايكروسوفت، الشريك الاستراتيجي لأوبن آي آي، أن كميات كبيرة من البيانات كانت تُستخرج من حسابات مطورين تابعة لأوبن آي آي أواخر عام 2024، فيما يُعتقد أن لهذه الحسابات صلة بديب سيك.

هل يُعد استخدام التقطير مخالفة قانونية؟

تقنية التقطير ليست أمراً نادراً في مجال الذكاء الاصطناعي، لكنها تتعارض مع شروط استخدام OpenAI، والتي تمنع استخدام مخرجات نماذجها في تطوير نماذج منافسة.

ومع ذلك، فمن المهم الإشارة إلى أن العديد من النماذج يمكن أن تُخطئ في تعريف نفسها أو تتشابه في استخدامها للتعابير والكلمات، خاصة في ظل تزايد ما يُعرف بـ “تلوث البيانات” على الإنترنت، إذ أصبح الويب يعج بمحتوى منخفض الجودة ناتج عن أدوات الذكاء الاصطناعي، تستخدمه مزارع المحتوى لصناعة منشورات ترويجية، فضلاً عن امتلاء منصات مثل Reddit وX بروبوتات الذكاء الاصطناعي.

هل استخدمت ديب سيك جيميناي فعلاً؟

يعتقد بعض الخبراء أن الاتهامات ليست بعيدة عن الواقع، وبهذا الصدد يقول الباحث ناثان لامبرت (Nathan Lambert) من معهد AI2 لأبحاث الذكاء الاصطناعي:

لو كنت مكان ديب سيك، لاستخدمت بالتأكيد أفضل نموذج API متاح لتوليد كميات هائلة من البيانات الاصطناعية، لديهم تمويل جيد لكن محدودية في موارد الـGPU، وهذا يُعد عملياً بمثابة “حوسبة مجانية”.

خطوات من OpenAI وGoogle وAnthropic لحماية نماذجها

في محاولة للحد من عمليات التقطير، اتخذت شركات الذكاء الاصطناعي خطوات أمنية متقدمة:

- في أبريل، بدأت OpenAI بفرض التحقق من الهوية عبر مستندات حكومية لاستخدام بعض النماذج المتقدمة، تجدر الإشارة إلى أن الصين ليست ضمن قائمة الدول المسموح بها عبر واجهة برمجة التطبيقات الخاصة بها.

- من جانبها، بدأت Google في تقليل إمكانية الوصول إلى “سلاسل التفكير” الناتجة عن نماذجها من خلال منصة AI Studio، ما يُصعِّب على المنافسين تدريب نماذج بناءً على جيميناي.

- كما أعلنت Anthropic في مايو أنها ستبدأ في تلخيص “آثار” نماذجها الخاصة لحماية ما وصفته بـ “الميزة التنافسية”.

رغم عدم وجود دليل دامغ حتى الآن، فإن الشكوك تزداد حول لجوء ديب سيك إلى مخرجات نماذج منافسة مثل جيميناي وشات جي بي تي في تدريب نماذجها الحديثة، وهي ممارسة قد تؤدي إلى مواجهة قانونية محتملة في حال ثبوتها.

ومع تنامي المخاوف من تكرار استخدام محتوى الذكاء الاصطناعي نفسه في تدريب النماذج الجديدة، يظل السباق بين شركات الذكاء الاصطناعي قائماً، ليس فقط على جودة النماذج، بل أيضاً على أخلاقيات التدريب وشفافية البيانات.

المصادر: