أنثروبيك تراجع سياسة الخصوصية وتعاملها مع بيانات المستخدمين

بيانات المستخدمين أصبحت مورداً ثميناً لتدريب النماذج الذكية وتطويرها

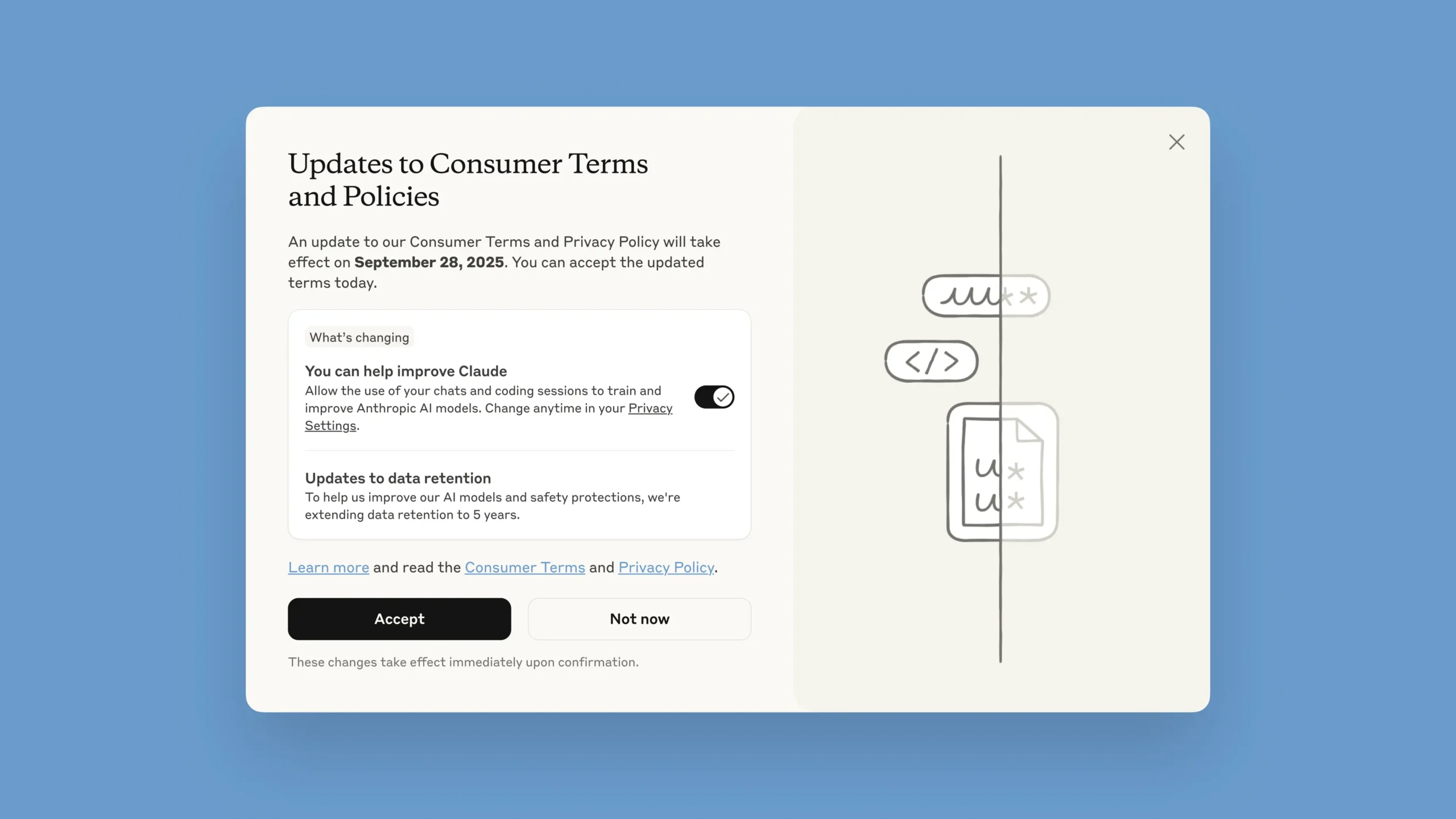

أعلنت شركة أنثروبيك تغييرات جذرية في سياسات التعامل مع بيانات المستخدمين، حيث سيتعين على جميع مستخدمي Claude Free وClaude Pro وClaude Max (بما في ذلك Claude Code) اتخاذ قرار بحلول 28 سبتمبر/أيلول 2025: إما الموافقة على استخدام محادثاتهم في تدريب نماذج الذكاء الاصطناعي، أو الانسحاب من المشاركة.

سياسة الخصوصية في أنثروبيك

سابقاً، لم تكن أنثروبيك تستخدم بيانات المحادثات الشخصية في تدريب النماذج، وكانت تقوم بحذفها خلال 30 يوماً (أو الاحتفاظ بها لعامين في حال وجود انتهاك للسياسات).

والآن، ستحتفظ الشركة ببيانات المستخدمين لمدة تصل إلى خمس سنوات إذا لم يختاروا الانسحاب.

أما العملاء من المؤسسات (Claude Gov، Claude for Work، Claude for Education، أو عبر واجهة API) فلن يتأثروا بهذه السياسة، وهو ما يشبه أسلوب أوبن إيه آي في حماية مستخدميها من فئة المؤسسات.

لماذا يحدث هذا الآن؟

بحسب بيان الشركة، فالهدف هو تحسين سلامة النماذج ودقتها، خاصة في اكتشاف المحتوى الضار وتحسين قدرات كلاود في البرمجة والتحليل.

لكن السبب الأعمق، من وجهة نظر الخبراء، هو حاجة أنثروبيك الماسَّة إلى بيانات محادثات حقيقية لتدريب نماذج الذكاء الاصطناعي بهدف منافسة شركات مثل أوبن إيه آي وجوجل في سباق تطوير النماذج الذكية.

المخاوف حول بيانات المستخدمين

يثير القرار قلقاً واسعاً لأن واجهة الإعدادات الجديدة تعرض زر “قبول” بارزاً، بينما خيار إلغاء المشاركة موضوع بخط أصغر ومفعل تلقائياً.

هذا التصميم قد يدفع المستخدمين للضغط على “قبول” دون إدراك أنهم يوافقون على مشاركة بياناتهم.

في السياق نفسه، حذَّر خبراء الخصوصية سابقاً من أن تعقيد سياسات الذكاء الاصطناعي يجعل الموافقة الواعية للمستخدم شبه مستحيلة.

السياق الأوسع

يأتي هذا التطور بينما تواجه أوبن إيه آي قضية قضائية تجبرها على الاحتفاظ بجميع محادثات شات جي بي تي إلى أجل غير مسمى، بما في ذلك المحذوفة.

بهذا الصدد، كانت لجنة التجارة الفيدرالية (FTC) قد حذَّرت الشركات من تغيير سياسة الخصوصية بشكل خفي أو دفن البنود في نصوص قانونية معقدة، معتبرةً ذلك انتهاكاً قد يستوجب إجراءات قانونية.

أخيراً، تعكس خطوة أنثروبيك تحولاً واسعاً في صناعة الذكاء الاصطناعي، حيث تصبح بيانات المستخدمين مورداً ثميناً لتدريب النماذج الذكية وتطويرها.

وفي المقابل، تتزايد المخاطر المرتبطة بخصوصية بيانات المستخدمين وشفافية السياسات، ما يضعهم أمام معضلة حقيقية بين المساهمة في تحسين النماذج أو الحفاظ على خصوصيتهم.

المصادر: