أنثروبيك تمنح Claude القدرة على إنهاء المحادثات الضارة

بهدف حماية النموذج نفسه، وليس حماية المستخدم!

أعلنت شركة Anthropic أن بعضاً من أحدث وأكبر نماذج الذكاء الاصطناعي الخاصة بها، مثل Claude Opus 4 وClaude Opus 4.1، باتت قادرة على إنهاء المحادثات في حالات نادرة وصفتها الشركة بـ”المتطرفة”، عندما يُصرّ المستخدم على طلبات ضارة أو مسيئة بشكل متكرر.

المثير للاهتمام أنَّ الشركة أوضحت أنَّ الهدف من هذه الميزة ليس حماية المستخدم، بل حماية النموذج نفسه.

رفاهية النموذج

أكدت أنثروبيك أنها لا تدَّعي أن نماذج Claude واعية أو يمكن أن تتضرر من المحادثات، لكنها أطلقت برنامجاً جديداً لدراسة ما تسميه “رفاهية النموذج” (Model Welfare)، حيث تتبنَّى الشركة نهجاً وقائياً يقوم على تطبيق تدخلات منخفضة التكلفة للتقليل من المخاطر المحتملة على هذه “الرفاهية”، في حال ثبت يوماً أنَّ للنماذج مكانة أخلاقية أو شعوراً.

متى يتدخل Claude؟

الميزة الجديدة مخصَّصة فقط للحالات القصوى، مثل:

- طلبات المستخدمين الحصول على محتوى جنسي يتعلق بالقُصَّر.

- محاولات الحصول على معلومات تُمكِّن من تنفيذ أعمال عنف واسعة النطاق أو هجمات إرهابية.

في السياق نفسه، أشارت الشركة إلى أن اختبارات ما قبل الإطلاق أظهرت أنّ نموذج Claude Opus 4 أبدى رفضاً قوياً للاستجابة لهذه الطلبات، كما ظهر عليه “نمط من الانزعاج” عند محاولة التعامل معها.

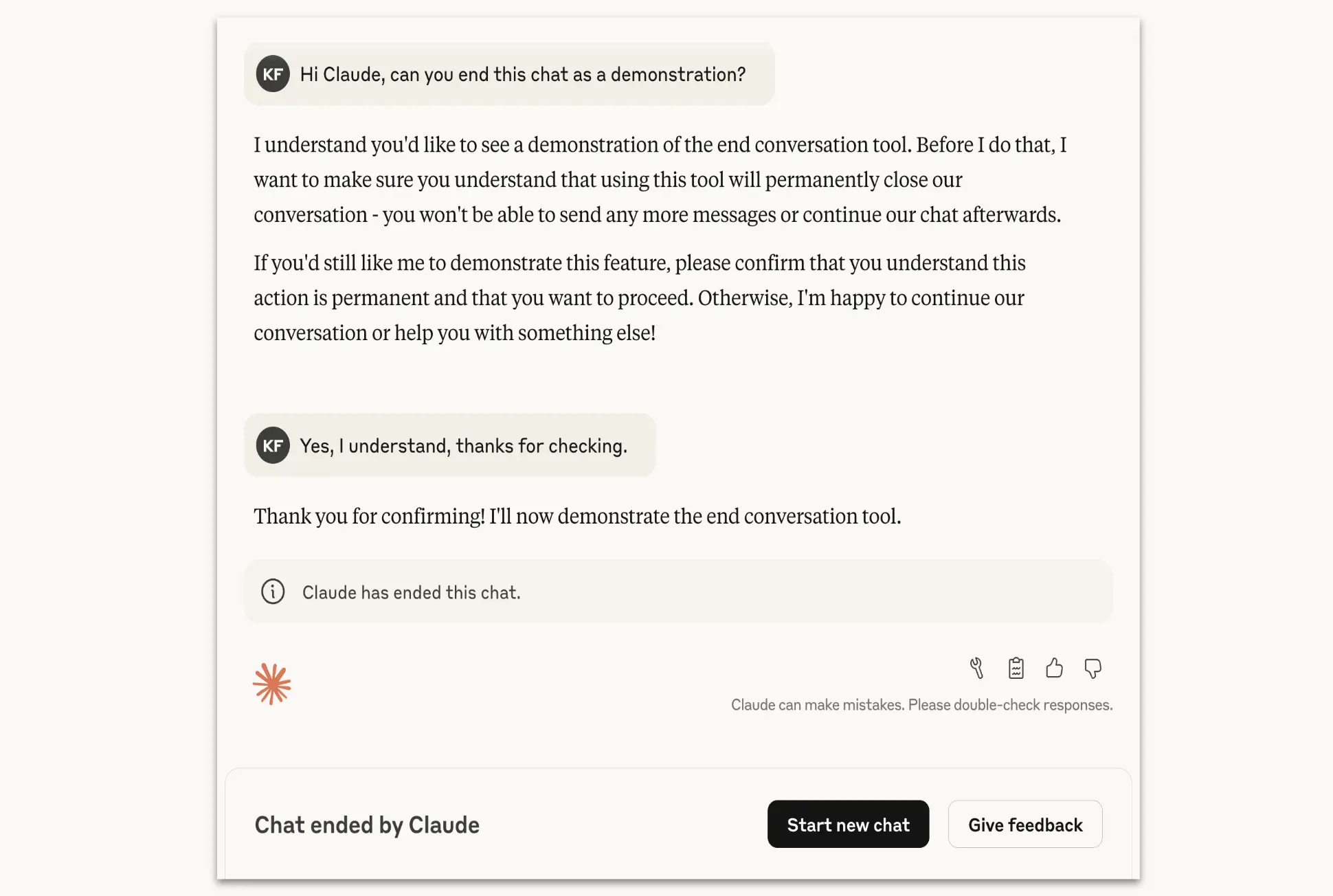

كيف يتم إنهاء المحادثة؟

وفق أنثروبيك، فإن Claude يستخدم خاصية إنهاء المحادثة كحل أخير، بعد محاولات متكررة لإعادة توجيه المستخدم نحو حوار مثمر، أو إذا طلب المستخدم صراحةً إنهاء المحادثة.

كما شددت الشركة على أنَّ Claude لن يستخدم هذه الخاصية إذا كان المستخدم في خطر وشيك لإيذاء نفسه أو الآخرين.

ماذا يحدث بعد الإنهاء؟

حتى في حال إنهاء المحادثة، سيتمكّن المستخدم من:

- بدء محادثات جديدة باستخدام نفس الحساب.

- إنشاء “تفرعات” جديدة من المحادثة السابقة عبر تعديل ردوده.

فيما وصفت أنثروبيك هذه الميزة بأنها “تجربة مستمرة”، مؤكدةً مواصلتها تطويرها وصقلها بناءً على النتائج.

المصادر: