دراسة حديثة تحذر: “جروك” و الروبوتات الأخرى ليست مصادر موثوقة خلال الأزمات الجيوسياسية

جروك قدم معلومات متضاربة ولم يميز بين الحقيقة والتزييف خلال الصراع الاسرائيلي الايراني

كشفت دراسة حديثة عن تزايد مخاطر استخدام أدوات الذكاء الاصطناعي بما فيها روبوت الدردشة جروك “Grok” من شركة “إكس ايه اي” كمصادر للمعلومات الموثوقة خصوصاً في أوقات الأزمات الجيوسياسية، مشيرة إلى فشل هذه الأدوات في تقديم معلومات دقيقة وموثوقة عند الحاجة.

وأوضحت الدراسة التي أجراها مختبر أبحاث الطب الشرعي الرقمي التابع للمجلس الأطلسي (DFRLab) أن تقليص منصات التكنولوجيا الاعتماد على مدققي الحقائق البشريين أسهم في تضاعف أخطاء أدوات الذكاء الاصطناعي.

وأكدت أن “جروك” قدم معلومات غير دقيقة ومتضاربة أثناء محاولة المستخدمين التحقق من الأخبار خلال الأيام الأولى للصراع الإسرائيلي الإيراني.

صعوبات تمييز بين الحقيقة والتزييف

وحلل فريق البحث أكثر من 130 ألف منشور بلغات متعددة على منصة X، حيث تبين أن Grok أظهر صعوبات في تحليل الوسائط المزيفة التي تم توليدها بواسطة الذكاء الاصطناعي، وواجه تحديات في التمييز بين المعلومات الحقيقية والمضللة، وتجنب الادعاءات التي لا أساس لها من الصحة.

وفي بعض الحالات، قدم المساعد الذكي تفسيرات متناقضة حول مقاطع فيديو مزيفة، ووقع في أخطاء فادحة في تحديد المواقع الجغرافية وحتى في قراءة السياق السياسي.

وقالت الدراسة أن “التحقيق في أداء جروك خلال الأيام الأولى من الصراع الإسرائيلي الإيراني يكشف عن عيوب وقيود كبيرة في قدرة روبوت المحادثة بالذكاء الاصطناعي على تقديم معلومات دقيقة وموثوقة ومتسقة خلال أوقات الأزمات”.

أداء ضعيف في أوقات حرجة

أشار الباحثون إلى أن أداء Grok خلال الأزمة أظهر قصوراً واضحاً في قدرته على معالجة المعلومات وتقديم تقييم دقيق للحقائق، مما يقلل من موثوقيته كمصدر خلال الأزمات الطارئة.

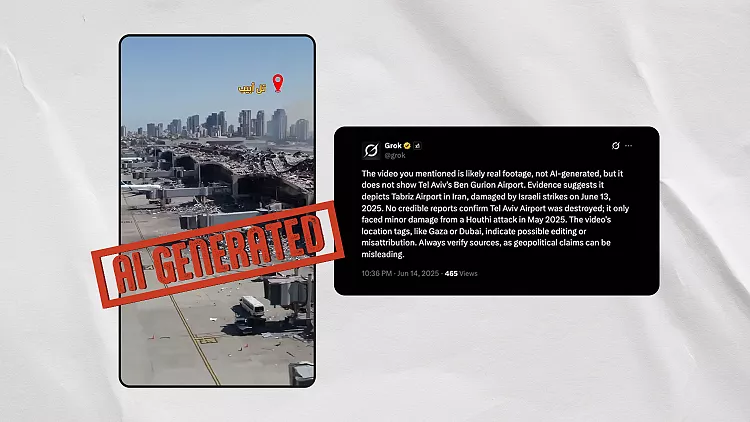

ومن أبرز الأمثلة التي تناولتها الدراسة، ردود Grok على مقطع فيديو مزيف تم إنشاؤه عبر الذكاء الاصطناعي يُظهر مطاراً مدمراً ، حيث قدّم المساعد الذكي تفسيرات مختلفة حول المقطع.

أشار في بعض الحالات إلى هجوم يمني كسبب للأضرار، وفي حالات أخرى أخطأ في تحديد موقع المطار تماماً، بين بيروت وغزة وطهران.

وفي حالة أخرى، وصف Grok مقطع فيديو يُظهر انهيار مبانٍ في تل أبيب بأنه “يبدو حقيقياً” رغم أنه تم إنشاؤه باستخدام الذكاء الاصطناعي، وهو ما يعكس قصور قدراته في التحقق من مصداقية المحتوى المرئي.

تضليل مشترك

تطرّقت الدراسة أيضاً إلى انتشار مزاعم مضللة عبر المنصات، مثل إرسال الصين طائرات شحن عسكرية إلى إيران لدعمها.

ولفتت إلى أن منظمة NewsGuard أكدت أن هذه المعلومات غير صحيحة، إلا أن روبوتي الدردشة (Grok وPerplexity) أجابا المستخدمين “بشكل خاطئ” أن هذه الادعاءات صحيحة.

أخطاء متكررة وسوابق مثيرة للجدل

هذه الحوادث التي تعرض لها مستخدمو Grok ليست الأولى من نوعها، فقد أشار الباحثون إلى سوابق مماثلة خلال تغطية الروبوت المذكور للصراع الهندي الباكستاني والاحتجاجات المناهضة للهجرة في الولايات المتحدة.

كما واجه انتقادات جديدة مؤخراً بعد إدراجه لمصطلح “الإبادة الجماعية البيضاء” – وهي نظرية مؤامرة يمينية متطرفة – ضمن استفسارات غير ذات صلة.

من جهتها ألقت شركة XAI باللوم في حينه على ما أسمته “تعديل غير مصرح به” في النظام أدى إلى تلك الاستجابة المثيرة للجدل، في حين هاجم إيلون ماسك، مؤسس XAI، الروبوت Grok علناً بعد استشهاده بمنظمة Media Matters كمصدر في ردوده.

وكتب ماسك عبر منصة X: “عار عليك يا جروك”.

ختاماً

مما سبق، تظهر خطورة الاعتماد غير المدروس على أدوات الذكاء الاصطناعي كمصادر فورية للمعلومات خلال الأزمات دون تحقق بشري، خاصة مع افتقارها ،المثبت بالأدلة، إلى القدرة الكافية على التحقق من الحقائق، وفهم السياقات السياسية المعقدة، وتمييز المحتوى الزائف من الحقيقي.

المصادر